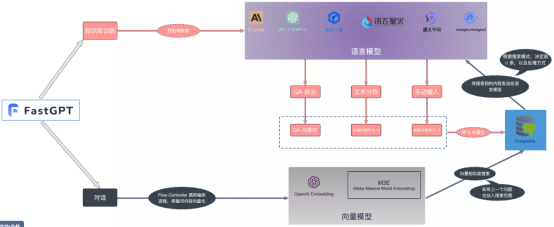

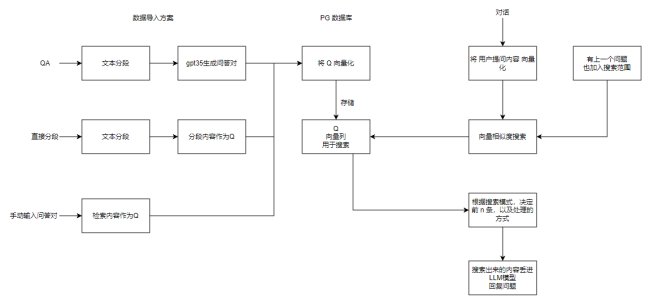

主要是分享FastGTP开源项目实现方案,FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,它有简单易用的可视化界面、自动数据预处理、工作流编排、强大的 API 集成等功能

一、系统架构图如下:

二、准备工作

1、搭建过程共分为四步,分别如下:LLM语言模型搭建、M3E向量模型搭建、ONE-API搭建、FastGTP环境搭建

本环境采用docker布署,对应docker和docker-compose版本如下:

docker:Docker version 26.0.1, build d260a54

docker-compose:Docker Compose version ......

专注JAVA系统优化、系统结构调整、系统问题排查医治、系统升级、架构设计、SQL语句优化、小程序、APP、企业应用软件开发,请 + hekf888,欢迎关注,时常发布技术分享博文